环境:Windows

第一步,安装 Ollama

下载 Ollama,官网 https://ollama.com/。

下载完成后,直接运行安装程序 OllamaSetup.exe,会自动安装到 C 盘。无法自定义安装路径。

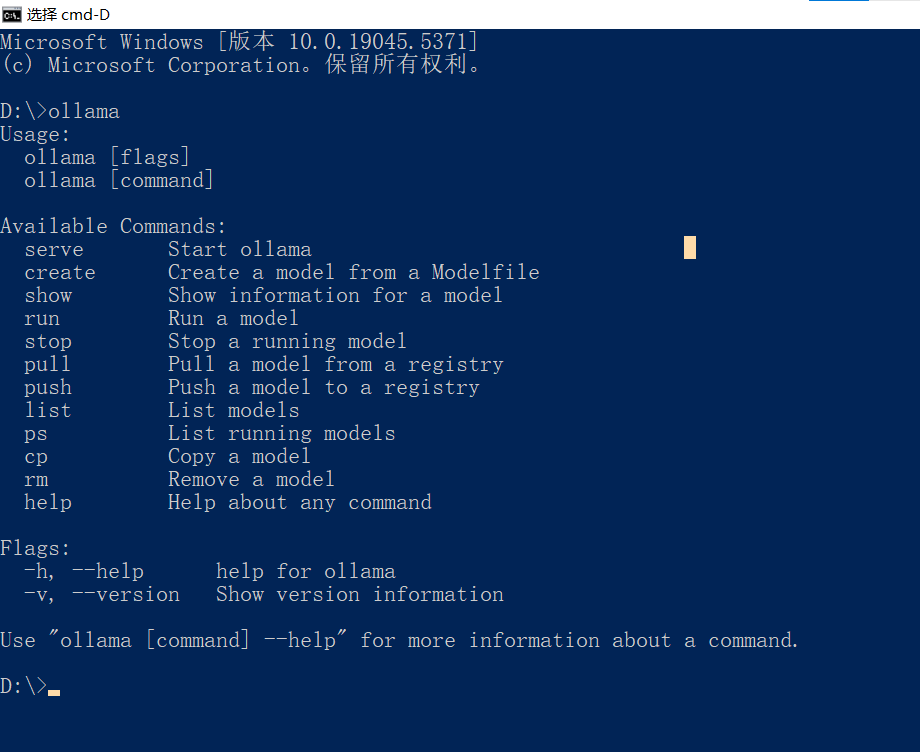

安装完成后打开命令行提示符,输入 ollama,显示帮助信息则安装完成。

第二步,下载 DeepSeek 模型

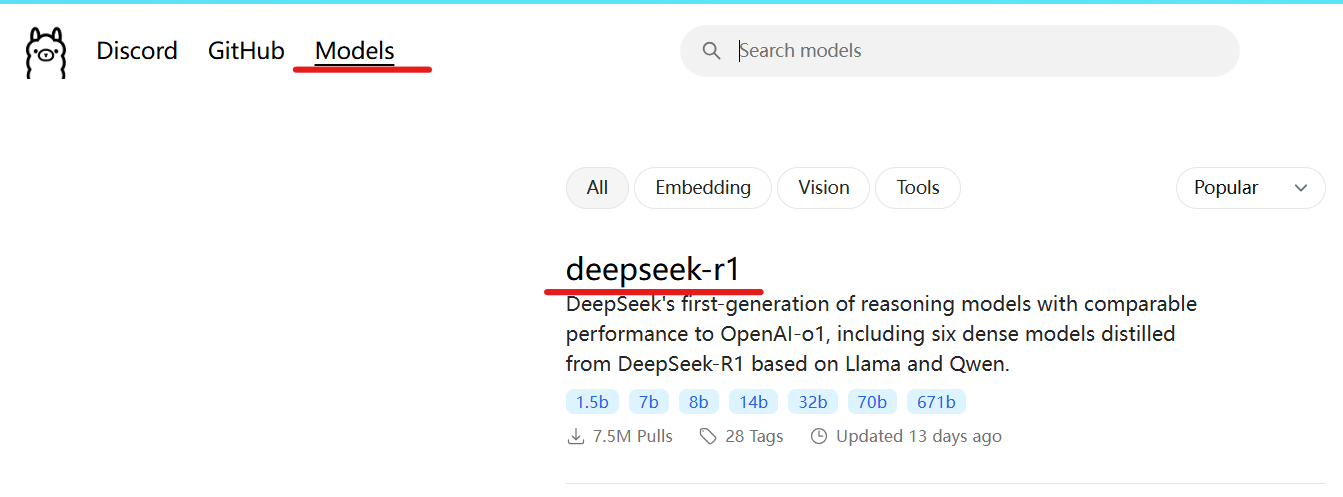

Ollama 官网 Models 一栏下点击 deepseek-r1 :

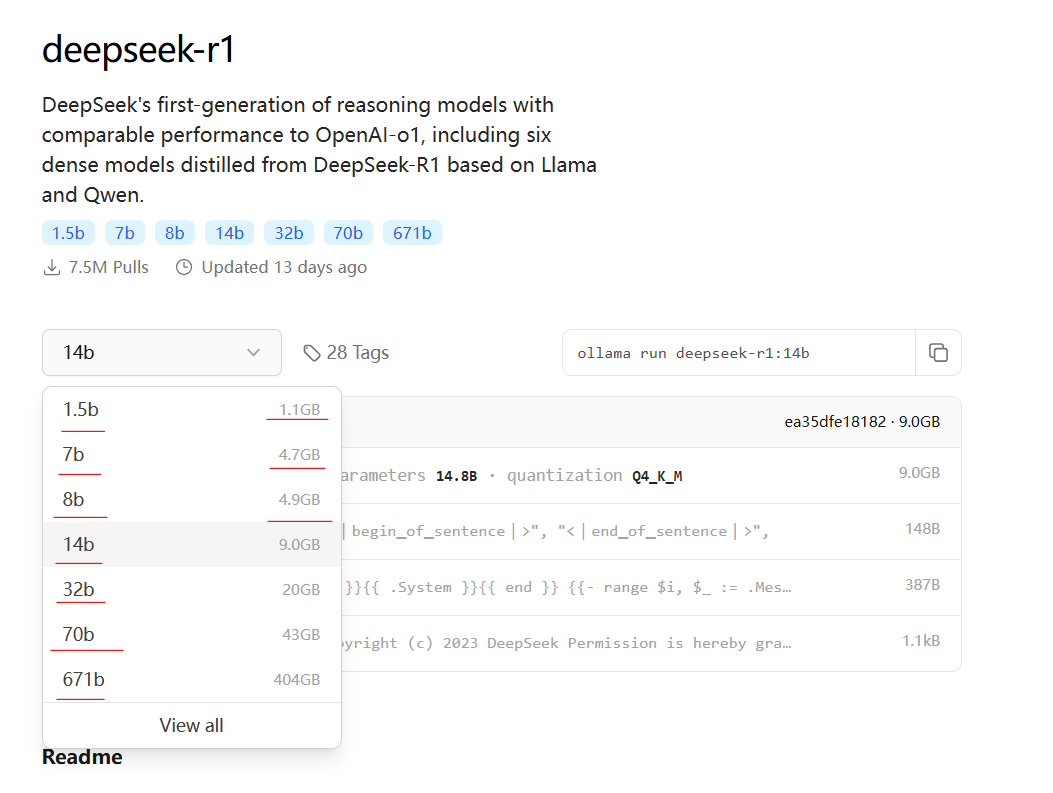

选择自己想要的模型:

前面的 1.5b、7b、8b … … 这些是模型的参数规模,单位是 billion (十亿)。

后面的则是不同模型所占的硬盘大小。

我的设备是轻薄本,显卡型号为 NVIDIA GeForce MX350,显存为 10GB。设备性能不是很好,所以我选择的是 14b 参数的模型。(在我的设备上运行起来,思考速度略慢一些,不过在可接受范围内。)

打开命令行,运行命令 ollama run deepseek-r1:[参数规模],该命令会自动将指定参数规模的人工智能大模型下载到本地并运行:

运行时需要显卡的算力,确保显卡的性能足够模型的运行。(优先使用显卡的算力,如果显卡不支持,则使用 CPU 的算力。)

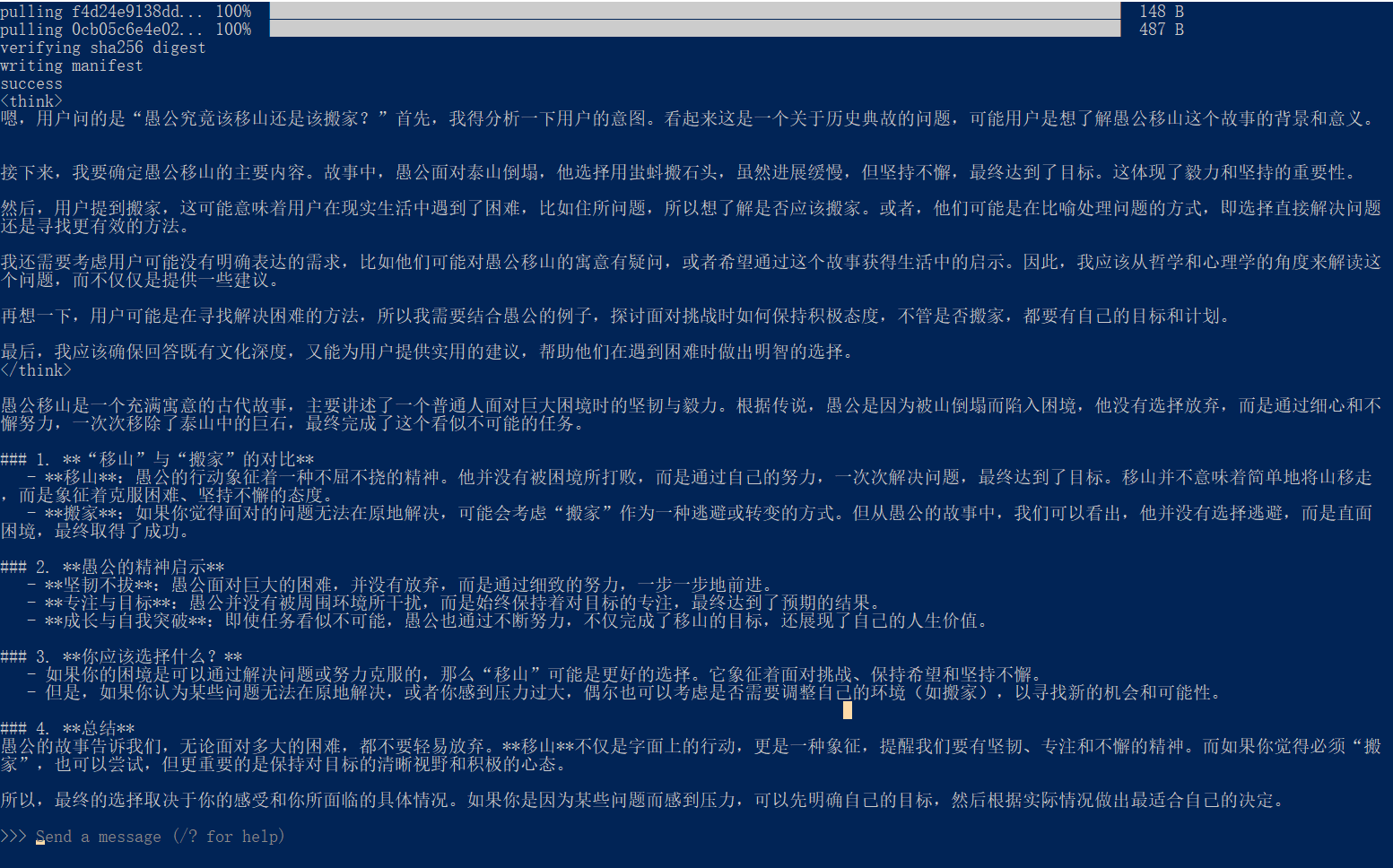

模型下载完成后,就可以在命令行和他进行互动了,问他一个愚公移山的问题,看他回答如何:

第三步,配置图形化界面

在命令行上和 deepseek 对话,他输出的内容是 markdown 格式的文本,看起来不是很友好。可以使用 Chatbox 连接 ollama 的进程,将 deepseek 的 markdown 格式的回答渲染成图形界面。

下载 Chatbox,官网 https://chatboxai.app/ 。Free Download (for Windows)

运行下载的安装程序,安装完成后打开,选择本地的 API,下拉栏选择 OLLAMA API,API 域名会自动填充,如果下载了多个 deepseek 模型,可以选择其版本,最后点击保存:

然后就可以使用图形界面和 deepseek 进行对话了:(问他一个数学方面的问题)

他的回答是正确的!还给出了具体的思考过程。

OK,简单总结一下。把 deepseek-r1 模型下载到自己的电脑上运行,缺点是回答速度有点慢(跟设备性能有关);优点是不需要联网,完全运行在自己电脑,断网的时候也可以用。智能程度方面,我觉得还不错,可以写一些简单的算法,回答一些简单的数学问题,中英文翻译不在话下,可以拿来练英语。总体使用体验还不错,感兴趣的朋友可以尝试玩一下。